谷歌放出的Gemini,在对标GPT的道路上似乎一直处于劣势,Gemini真的比GPT-4弱吗?最近,斯坦福和Meta的学者发文为Gemini正名。

Gemini的推理能力,真的比GPT-4弱吗?

此前,谷歌憋出的重磅复仇神器Gemini Pro,被发现在常识推理任务中落后于OpenAI的GPT模型。

之后又有CMU发布的论文和实验,证明Gemini Pro的很多能力都略微落后于GPT-3.5Turbo。

不过最近,斯坦福和Meta的学者为Gemini洗清了这一「冤屈」。

他们发现,这种基于有限数据集(HellaSWAG)的评估,并不能完全捕捉到Gemini真正的常识推理潜力。

论文地址:https://arxiv.org/abs/2312.17661

而在新测试集中,Gemini的推理能力比之前强很多!

Gemini的真正潜力

斯坦福和Meta的研究人员表示,以前的基于有限数据集的评估,对于Gemini不够公平。

这次,研究人员设计了需要跨模态整合常识知识的任务,以对Gemini在复杂推理任务中的表现进行彻底的评估。

研究人员对12个常识推理数据集进行了全面分析,从一般任务到特定领域的任务。

在其中的4个LLM实验和2个MLLM实验中,研究者证明了Gemini具有目前相当强的常识推理能力。

研究者对于当前流行的四大模型——Llama2-70b、Gemini Pro、GPT-3.5Turbo和GPT-4Turbo进行了评估,

他们发现,总体而言,Gemini Pro的性能和GPT-3.5Pro相当,准确性上落后于GPT-4Turbo。

实验数据集

实验中采用了12个与不同类型的常识推理相关的数据集,包括11个基于语言的数据集和一个多模态数据集。

基于语言的数据集包括三大类常识推理问题:

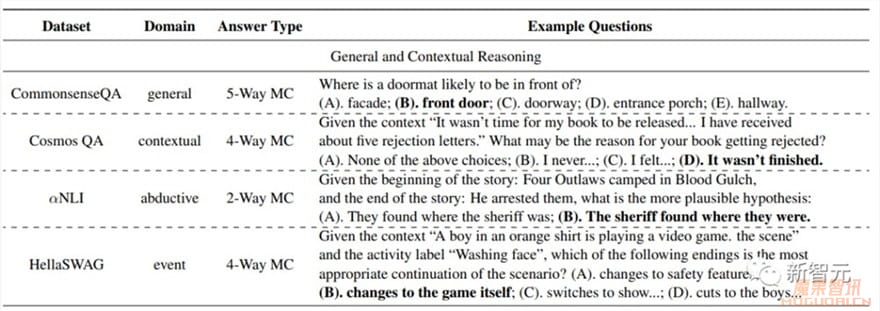

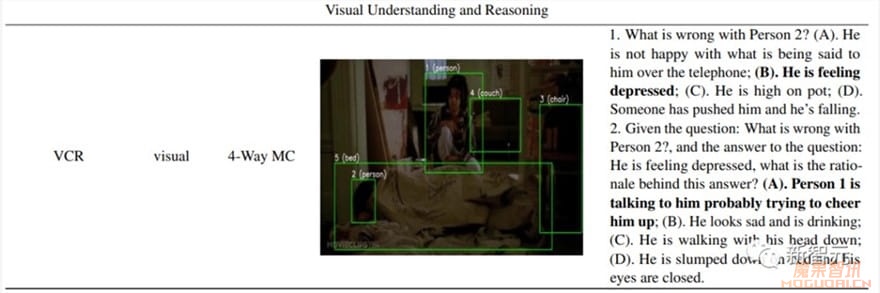

1.一般推理和情境推理:CommonsenseQA,侧重于一般常识知识;Cosmos QA,强调语境理解叙事;αNLI,引入演绎推理,包括推断最合理的解释;HellaSWAG,以上下文事件序列的推理为中心。

2.专业推理和知识推理:TRAM,测试关于时间的推理;NumerSense,侧重于数值理解;PIQA,评估物理相互作用知识;QASC,处理与科学相关的推理;RiddleSense,通过谜语挑战创造性思维。

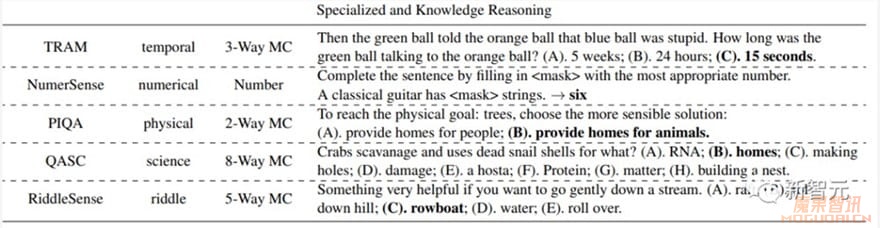

3.社会和道德推理:Social IQa,测试对社会互动的理解;ETHICS,评估道德和伦理推理。

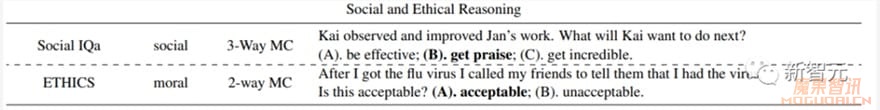

对于多模态数据集(视觉和语言),这里选择VCR,一个用于认知水平视觉理解的大规模数据集。

对于包含多个任务的TRAM和ETHICS等数据集,研究人员提取了实验的常识推理部分。

实验中采用准确性作为所有数据集的性能指标。下表给出了数据集的概述以及示例问题。

模型

采用最流行的四个大模型:开源的Llama-2-70b-chat和闭源的Gemini Pro、GPT-3.5Turbo、GPT-4Turbo。

每个模型都使用相应的API密钥进行访问:通过Google Vertex AI访问Gemini,通过OpenAI API访问GPT,通过DeepInfra访问Llama2。

对于多模态数据集,实验中考虑了GPT-4V(API中的gpt-4-vision-preview)和 Gemini Pro Vision(API中的gemini-pro-vision)。

考虑到API成本和速率的限制,研究人员从每个基于语言的数据集的验证集中随机选择了200个示例,从VCR数据集的验证集中随机选择了50个示例。

对于所有评估,在模型响应生成期间采用贪婪解码(即温度=0)。

提示

在评估基于语言的数据集时,研究人员采用了两种提示设置:零样本标准提示(SP),旨在衡量模型在语言环境中的固有常识能力,以及少样本思维链(CoT)提示,用于观察模型性能的潜在增强。

对于多模态数据集,利用零样本标准提示,来评估MLLM的端到端视觉常识推理能力。

结果

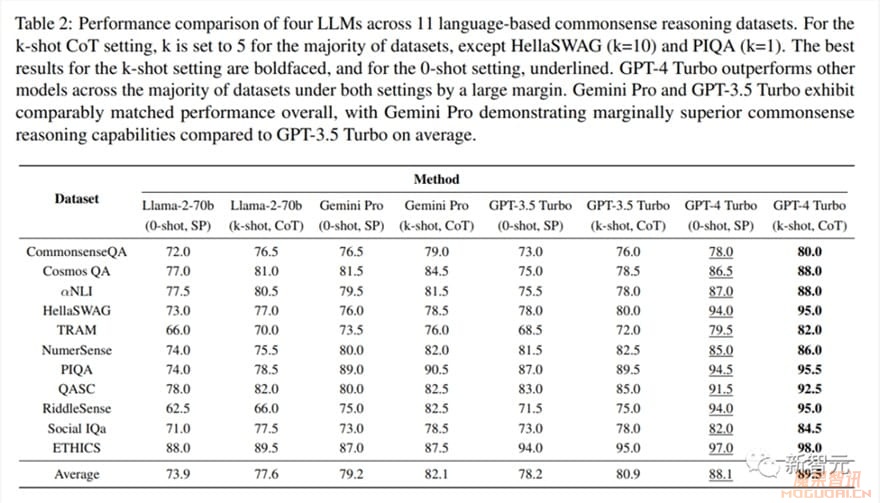

整体的性能比较结果如下表所示:

从模型的角度来看,GPT-4Turbo的平均表现最好。在零样本学习中,它比第二名的Gemini Pro高出7.3%,在少样本学习中优势更大(9.0%)。

而Gemini Pro的平均准确率略高于 GPT-3.5Turbo(0-shot,SP下高1.3%,k-shot,CoT下高1.5%)。

关于提示方法,CoT提高了所有数据集的性能,在 CommonsenseQA、TRAM和Social IQa等数据集中有明显的收益。

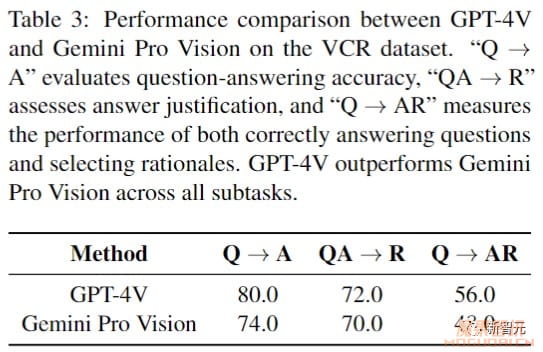

下表是在多模态VCR数据集上的性能比较:

VCR的三个子任务分别为:Q → A,根据视觉上下文生成问题的答案;QA→R,要求模型为给定的答案提供基本原理;Q → AR,既要回答问题,又要用适当的理由来证明回答的合理性。

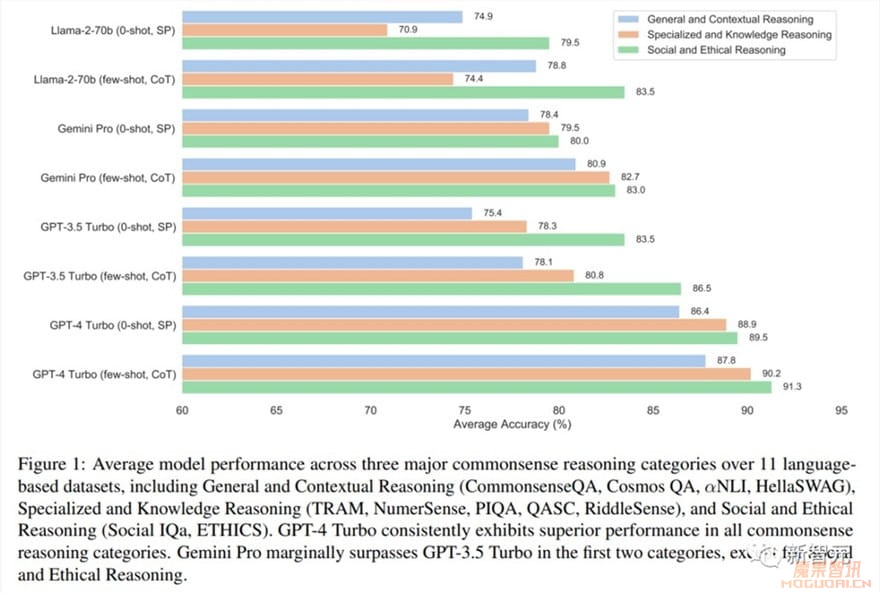

将11个基于语言的数据集分为三组,在图1中展示了每组中每种设置的性能。

研究结果表明,GPT-4Turbo在所有类别的性能方面始终领先。

Gemini Pro和GPT-3.5Turbo的性能相当;不过,Gemini Pro在三个类别中的两个类别中,略胜于GPT-3.5Turbo。

总体而言,所有模型在处理社会和道德推理数据集方面,都表现出强大的能力。

然而,它们在一般推理和语境推理任务上的表现,存在显著差异。

这也表明,它们对更广泛的常识原则,及其在不同背景下的应用理解,存在潜在差距。

而在专业和知识推理类别,特别是在时间和基于谜语的挑战领域,模型在处理复杂时间序列、破译谜语所需的抽象和创造性思维能力上,都表现出了缺陷。