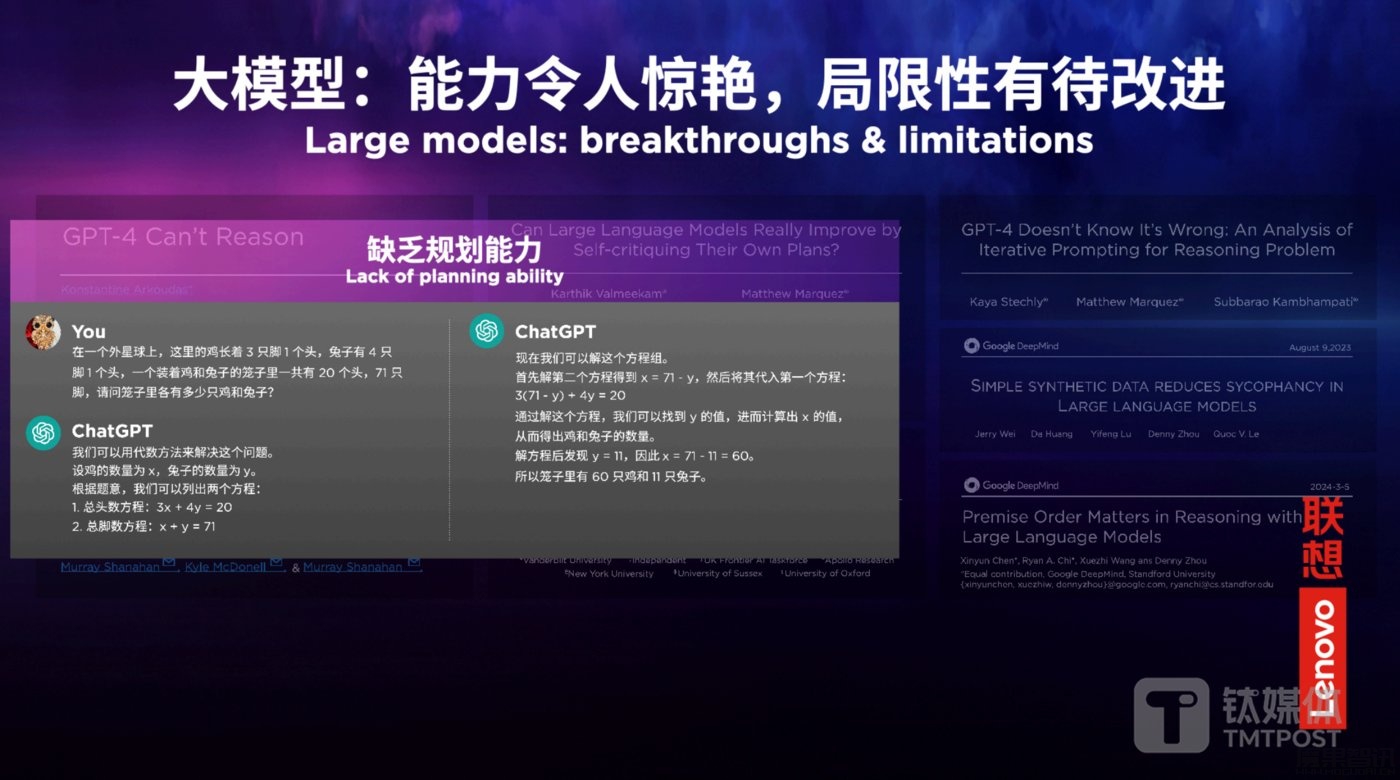

大模型能力令人惊艳,但局限性有待改进

大模型的出现可以说是AI历史上一个重要的里程碑,它开启了人工智能发展的新纪元,在过去的16个月里,由大模型引领的人工智能技术日新月异,模型参数从百亿到迁移,再到万亿;模型类型从语言模型到视频模型,再到音乐模型,涵盖了生活工作的方方面面。

我认为,AI历史发展至今,没有任何一个技术可以像今天的大模型一样强大。

但是,当我们觉得大模型要“一统天下”的时候,它的局限性也逐步显现出来。例如,小学时我们就学过的“鸡兔同笼”的数学问题,如果直接提问给大模型,即使它做对了,人们也不知道大模型是真正理解了问题,还是仅仅是记住了训练的数据。

通过这个例子可以看出,今天的大模型没有真正理解语言,没有真正理解世界,也没有真正具备推理和规划的能力。现在的大模型仅仅是根据高维语义空间和联合概率分布,将它训练的数据中的海量片段进行简单的逻辑性的连接。而这种状态下的大模型虽然很强大,但局限性也很强。

要想突破这种局限性,我们不能再单纯地利用大数据+大算力+大网络的方式,堆砌大模型,而是要超越大模型,探索更接近人类思维方式和行为方式的人工智能。

大模型的下一步是智能体

基于上述观点,我认为,大模型发展的下一步是:基于大模型的智能体。大模型的优势与缺点都很明显,优势是具备强大的能力,缺点是局限性很强。

基于此,我们要“扬长长短”。“扬长”是要持续发挥并不断增强大模型的能力;“长短”是要打造基于大模型的智能体技术,真正能解决应用场景中遇见的问题。而这也是联想的发展理念,左手抓大模型,右手抓智能体,两手都要抓,两手都要硬。

在“左手”——增强大模型方面,从技术角度出发。增强大模型方面有四个混合技术方向:

首先,小模型不会消失。未来一定是基于大模型和小模型混合的“意图理解”技术。信息论里熵entropy是度量信息量的单位,越有序,熵越小,越无序,熵越大。使用交叉熵cross entropy损失最小化原则,将意图理解任务最优地分配给大模型和小模型,从而兼顾精准度和复杂性。

第二,未来一定是基于CPU、GPU、NPU混合调度的异构计算的天下。如今,大模型的训练和推理过程中,瓶颈往往不在于芯片算力,而在于数据传输。通过同时优化计算负载和数据传输的方式,使总体执行时间缩短。

第三,基于模型微调(SFT) 与检索增强(RAG) 混合的“智能问答”技术是最佳选择。模型微调(SFT) 与检索增强(RAG) 各有利弊,通过协同优化的方式,让模型微调(SFT) 与检索增强(RAG) 相向而行,从而达到最优结果。

第四,基于硬件加密与全栈可信架构的混合“隐私安全”技术。在安全领域,仅靠硬件不够,仅靠软件业不够,尤其是在后量子时代,通过在高维实数空间里进行因式分解进行加密将成为未来安全的重要趋势。

而这四类混合技术就需要云边端的协同,需要软硬件的协同,需要传输与计算的协同。

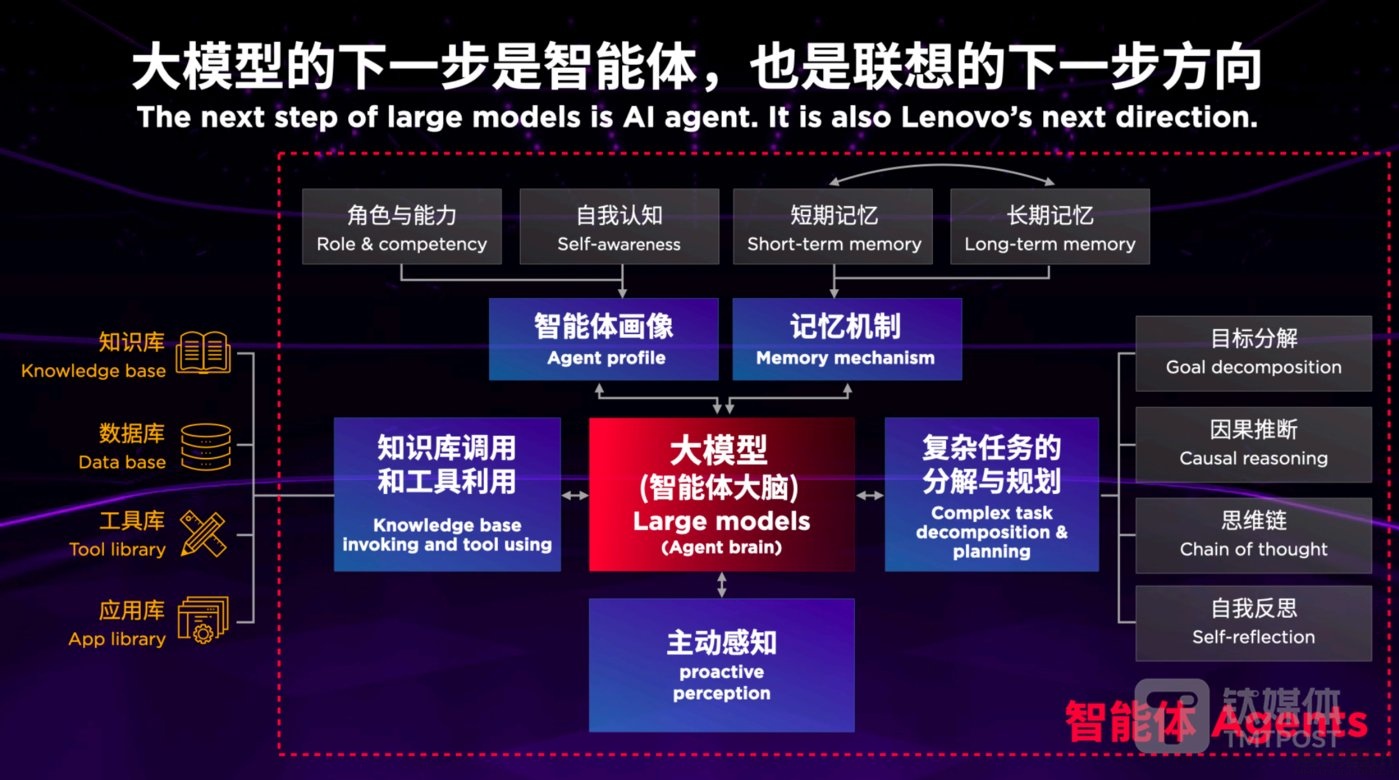

在“右手”——智能体方面,如何打造智能体是我们面临的问题。虽然大模型不是万能的,但是没有大模型是万万不能的。未来,大模型将占据“C位”,作为整体的控制中枢,但仅依靠大模型又远远不够。

怎么做呢?首先,要让智能体具有知道自身能力边界的能力,就好像人一样(人也是一个智能体),每个人都知道自身能力的边界。例如,你问我“茴”字如何写?我能告诉你,草字头,下面是个“回”。因为这个在我能力边界内。但如果问我“茴”的四种写法,这就超过了我得能力边界,我会通过查字典,上网查询等方式,查找答案。

回到大模型领域,不具备认知自身能力边界的能力,就使得大模型有时候会非常自信地告诉人们错误答案。

除了自我认知的能力,一个完整的智能体还要具备包括主动感知,意图理解,复杂任务分解,以及长短期记忆机制等在内的多种能力。

综上,大模型的下一步是智能体,智能体基于大模型而又超越大模型。