2月13日讯 近日,微软和苏黎世联邦理工学院的研究人员联合开源了 SliceGPT,该技术可以极限压缩大模型的权重矩阵,将模型体量压缩25% 左右,同时保持性能不变。实验数据显示,在保持零样本任务性能的情况下,SliceGPT 成功应用于多个大型模型,如 LLAMA-270B、OPT66B 和 Phi-2。

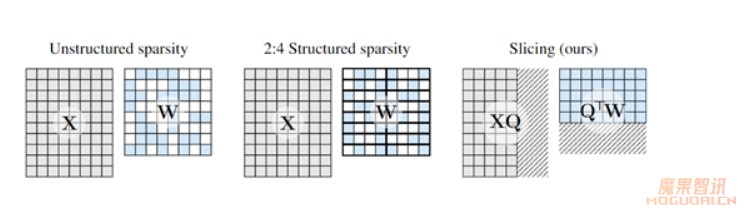

SliceGPT 的核心技术在于利用计算不变性来简化和压缩模型。通过对每个权重矩阵应用正交矩阵变换,SliceGPT 实现了对模型的极限压缩。此外,切片操作后的模型可以直接在消费级显卡上运行,如 N 卡的4090、4080,无需进行额外的代码优化,使得部署更加便捷。

在实验中,研究人员发现 SliceGPT 的切片技术非常简单高效,可以在几个小时内使用单个 GPU 完成模型压缩,无需复杂的细调过程。切片操作后的模型保持了高质量的生成任务性能,同时吞吐量得到提升,整体效果令人满意。

SliceGPT 的开源为压缩大模型提供了一种新颖且有效的途径,将大幅节省部署资源同时保持模型性能不变。这一技术的推出,有望为广大开发者和企业提供更加便捷、高效的大模型应用解决方案。

开源地址:https://github.com/microsoft/TransformerCompression

论文地址:https://arxiv.org/abs/2401.15024