7月3日讯 社交媒体 X 计划利用 AI 撰写社区注释(community notes),其目的是提高事实核查效率,但官方也承认存在明显风险。

该计划可能破坏用户对事实核查系统的信任,因为 AI 撰写的注释可能不准确且具有误导性。专家警告,AI 注释可能导致错误信息扩散,并可能加剧审查负担。

在最新研究论文中,X 平台将这一计划描述为一次“升级”,同时解释了 AI 撰写社区注释可能出现的所有问题。

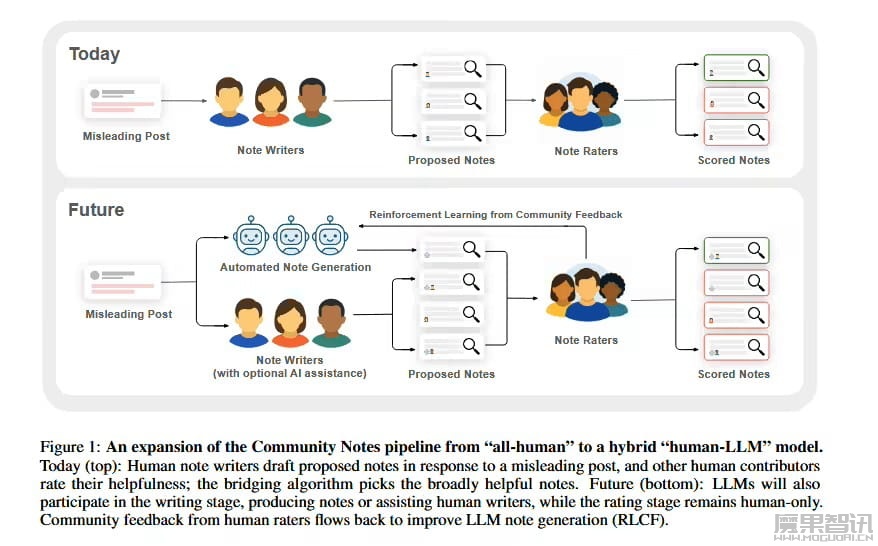

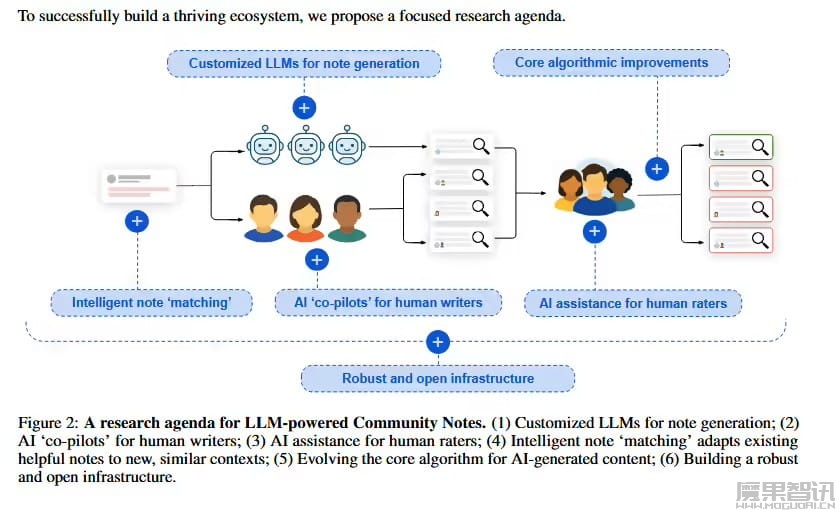

在理想情况下,X 平台描述了 AI 能够加速和增加错误帖子上的社区注释数量,从而提高平台范围内的事实核查力度。

每个 AI 撰写的注释将由人工审查员评分,为 AI 提供反馈,以改善其写作能力。随着 AI 写作能力提升,人工审查员可以专注于 AI 无法快速处理的更细微的事实核查任务,例如需要特定专业知识或社会意识的帖子。

如果一切顺利,人类和 AI 审查员将共同转变 X 的事实核查方式,甚至探索形成“公共知识生产中人类与 AI 合作的新形式”。

援引论文观点,然而,仍然存在一个关键问题:X 平台不确定 AI 撰写的注释是否能够像人类撰写的注释一样准确。

进一步复杂化的是,AI 可能会生成“有说服力但错误”的注释,人类评分员可能会因为 AI 在撰写有说服力、情感共鸣且看似中立的注释方面“异常擅长”而给予好评。这可能会破坏反馈循环,削弱社区注释的可信度,并随着时间的推移,让整个系统变得不那么可靠。

X 平台预测,如果无法解决这一难题,最重要的注释的影响可能会被稀释。一种可能的解决方案是取消人工审查流程,将 AI 撰写的注释应用于“类似上下文”的帖子,但最大的潜在问题是显而易见的:自动匹配人们认为不需要注释的帖子可能会显著削弱系统信任度。