2月18日讯 DeepSeek 今日官宣推出 NSA(Native Sparse Attention),这是一种硬件对齐且原生可训练的稀疏注意力机制,用于超快速长上下文训练与推理。

NSA 的核心组件包括:

- 动态分层稀疏策略

- 粗粒度 token 压缩

- 细粒度 token 选择

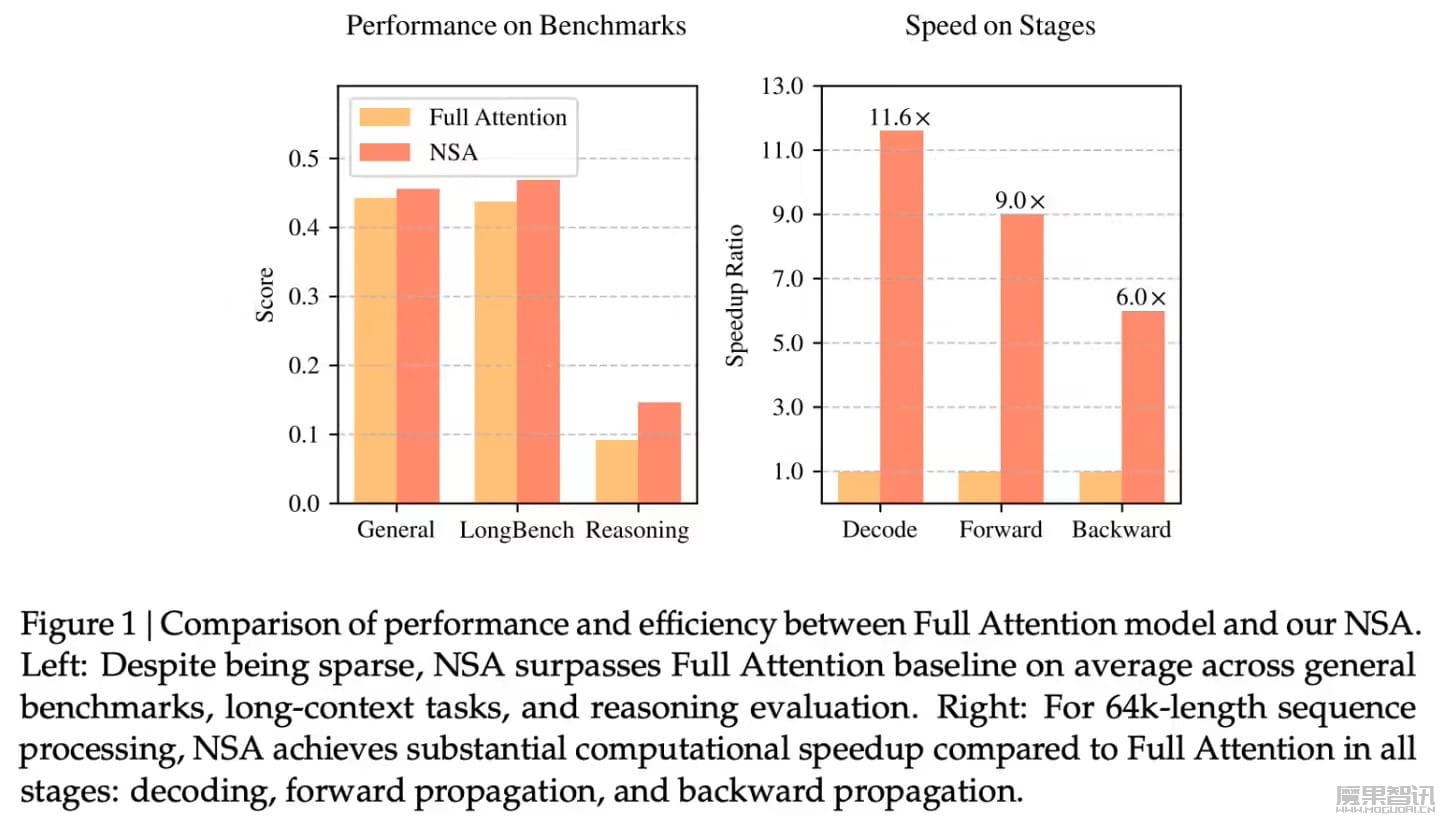

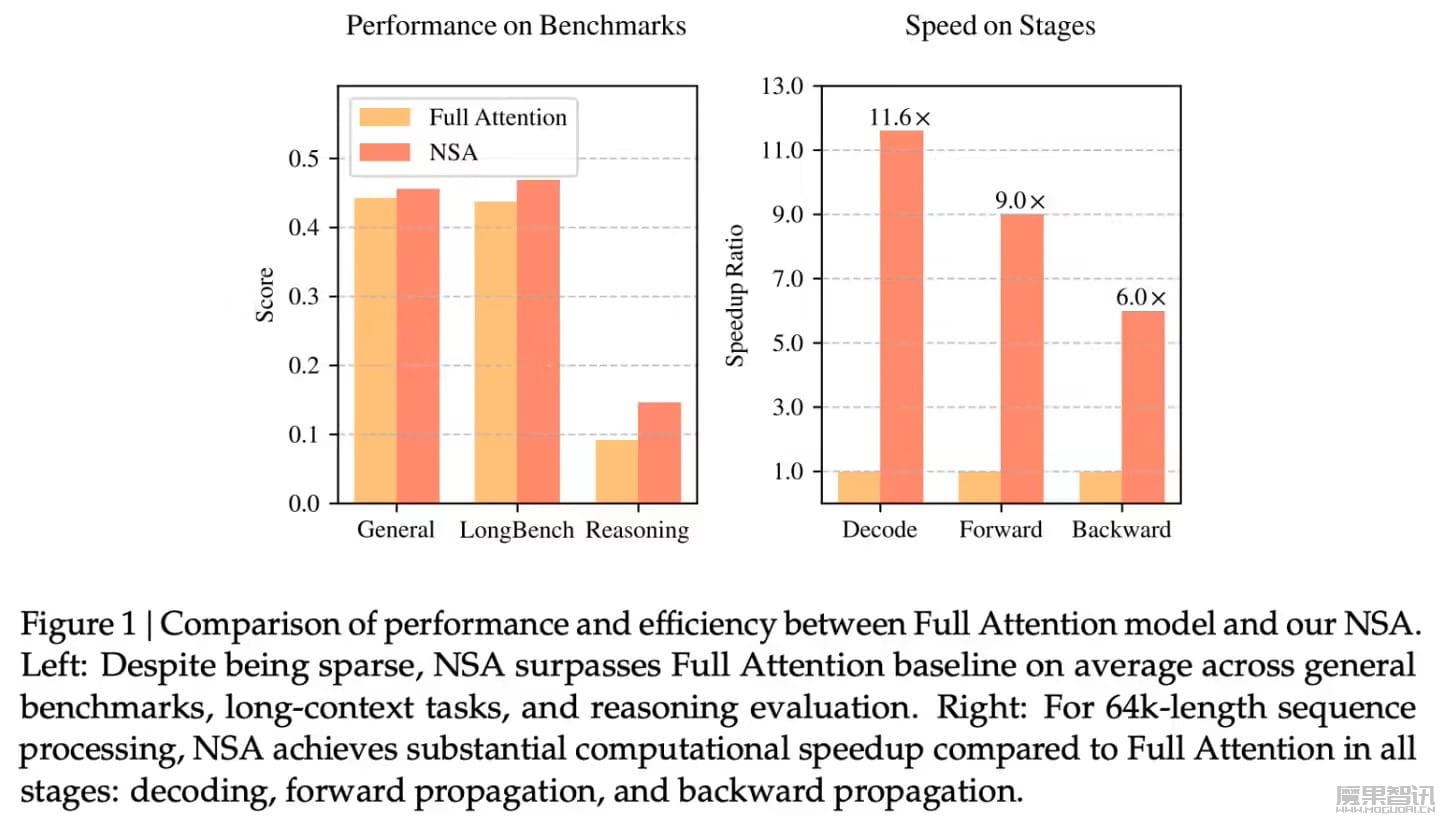

DeepSeek 官方表示,该机制可优化现代硬件设计,加速推理同时降低预训练成本,并且不牺牲性能。在通用基准、长上下文任务和基于指令的推理上,其表现与全注意力模型相当或更加优秀。

2月18日讯 DeepSeek 今日官宣推出 NSA(Native Sparse Attention),这是一种硬件对齐且原生可训练的稀疏注意力机制,用于超快速长上下文训练与推理。

NSA 的核心组件包括:

DeepSeek 官方表示,该机制可优化现代硬件设计,加速推理同时降低预训练成本,并且不牺牲性能。在通用基准、长上下文任务和基于指令的推理上,其表现与全注意力模型相当或更加优秀。

扫码打开当前页

之前

魔果智讯(moguoai.cn)是中国人工智能领域的专业媒体门户。本站汇集了最全面的人工智能新产业资讯及学科知识和学习资料,包括但不限于人工智能、机器人、无人驾驶、可穿戴、云计算等新兴技术信息资讯,坚持为从业者提供高质量内容和多项产业服务,是人工智能爱好者学习和交流不可或缺的平台。