11月8日讯 Meta 于上周发布新闻稿,宣布正式开源可在智能手机上运行的小语言模型 MobileLLM 家族,并同时为系列模型新增 600M、1B 和 1.5B 三种不同参数版本。

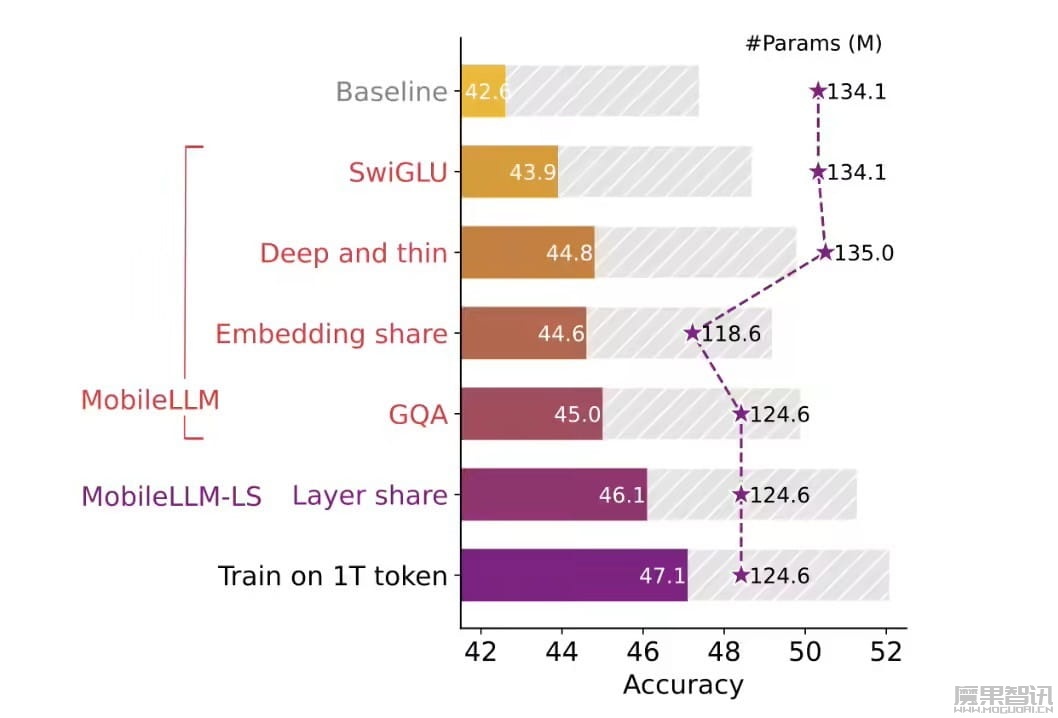

Meta 研究人员表示,MobileLLM 模型家族专为智能手机打造,该模型号称采用了精简架构,并引入了“SwiGLU 激活函数”、“分组查询注意力(grouped-query attention)”机制,能够在兼顾效率与表现成果。

此外,MobileLLM 模型据称训练速度较快,Meta 研究人员声称他们在 32 颗 Nvidia A100 80G GPU 的服务器环境下,以 1 万亿词(tokens)训练不同参数量的 MobileLLM 模型时,1.5B 版本只需 18 天,而 125M 版本仅需 3 天。

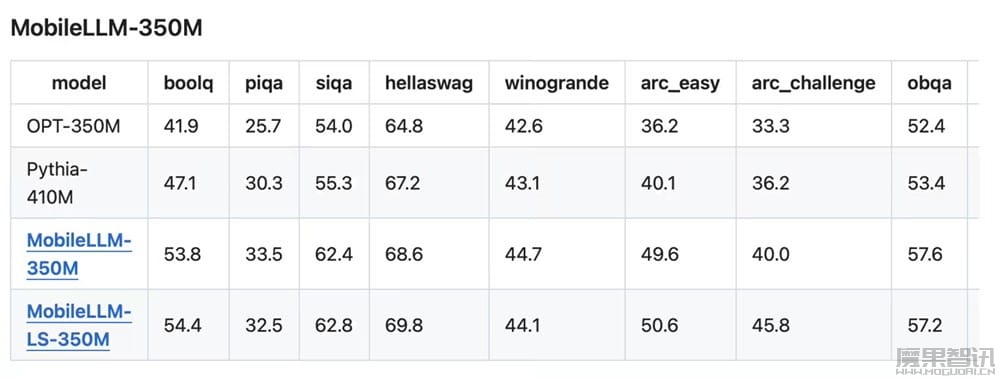

而从结果来看,MobileLLM 125M 和 350M 两款模型在零样本常识理解任务中的准确率比 Cerebras、OPT、BLOOM 等 State of the Art(SOTA)模型分别高出 2.7% 和 4.3%。

Meta 研究人员同时将 MobileLLM-1.5B 与业界其他参数量更大的模型进行比较,在结果测试方面据称领先 GPT-neo-2.7B、OPT-2.7B、BLOOM-3B、Qwen 1.5-1.8B 等模型。

GitHub 项目网页:https://github.com/facebookresearch/MobileLLM