AI大模型正在引发新一轮的“算力焦渴”。

近日,OpenAI刚发布的o1大模型再次刷新了大模型能力的上限。对比上一次迭代的版本,o1的推理能力全方位“吊打”了GPT-4o。更优秀的能力,来自与o1将思维链引入进了推理过程。在o1对问题“一边拆解一边回答”的过程中,“环环相扣”的思维链让答案也变得更加“靠谱”。

思考模式的升级,也意味着更大的算力需求。由于模型原理是在LLM训练额外添加了RL(强化学习)的Post-Training(后训练),这意味着一次推理和训练所需的算力将再次增加。

“AI研究中遇到的最大困难就是缺少算力——AI本质就是暴力计算。”华为副董事长、轮值董事长徐直军此前总结道。

于是,近几年科技大厂对AI基础设不断加大投入,除了英伟达股价不断升高,卖“AI铲子”的AI服务器厂商们也在本季度迎来了翻倍的业绩增长。

并且,随着AI算力下一步的需求增长和基础设施下放,服务器厂商们有望凭借AI赚得越来越多。

厂商们业绩的“高歌猛进”,是服务器与AI深度结合的结果。

其中在AI训练环节,服务器大厂们纷纷采用不同方式加速整个AI训练过程,让异构计算的AI服务器,成为一台高效的AI训练任务“分发机”。另一边,在解决算力硬件紧缺的问题中,AI服务器厂商也结合大型服务器集群的运营经验,落地了各种让英伟达、AMD、华为昇腾、Intel等厂商GPU混训大模型的平台。

伴随着对AI从训练到硬件优化的深入理解,越来越了解AI的服务器厂商也在从原本卖硬件组装的身份,提升着在AI产业链的价值。

其中,聚焦到智算中心建设层面,不少服务器厂商已经根据AI需求调整了AI服务器集群的硬件基础设施。并且,随着对国产算力芯片的深度结合,基于AI服务器厂商自己定制的解决方案正在广泛落地。

另一边在软件层面,更懂AI的服务器厂商也在开始挖掘AI在基础设施中的生产力属性。伴随着服务器厂商推出的AI大模型、Agent,服务器厂商与AI应用客户业务的结合也愈发紧密,从而进一步获得更多软件层面的解决方案收入。

毫无疑问,AI时代的变革也改变了整个算力载体的行业逻辑。

AI服务器厂商们正在以各种方式为用户带来更密集、更高效的算力供应。在当下的“算力焦渴”时代,AI服务器厂商正在成为愈发重要的“卖水人”。

AI行业,“卖铲子”的先赚钱了

AI大厂们的加速投入,让“卖铲子”的AI服务器厂商开始赚钱了。

根据IT桔子数据显示,截止到9月1日,AI相关上市公司整体还是亏损居多。其中,15家盈利的AI上市公司累计净利润为27.8亿元,亏损的19家累计净额为62.4亿元。

AI尚不能让行业实现整体盈利,一个原因是AI巨头们仍处于加速投入阶段。

据统计,今年上半年,国内三家AI巨头(BAT)在AI基础设施上的资本支出总额高达500亿元人民币,比去年同期的230亿元人民币,增长了一倍多。全球范围,随着亚马逊在上季度增长了18%的固定资本开支,再次进入了资本扩张周期。微软、亚马逊、谷歌、Meta等美股“Mag7”们,也达成了继续加码AI的共识。

“对AI投资不足的风险,远超投资过度风险。”谷歌母公司Alphabet首席执行官Sundar Pichai显然非常激进,并不认为目前是投资泡沫。

而借着加大投入的风口,提供AI基础设施的AI服务器玩家们“大赚特赚”。

其中,全球老牌服务器厂商惠普和戴尔在AI时代迎来了“第二春”。根据惠普最新披露的业绩(2024三季度)显示,其服务器业务同比增长35.1%。戴尔上季度财报显示(对应2024年5月—2024年7月),其服务器和网络业务营收同比增长80%。

同样在国内厂商中,联想在最新一季财报中提到,受AI需求增长,其基础设施方案业务集团季度收入首次突破30亿美元,同比增长65%。浪潮的中报数据显示,公司实现归属于上市公司股东的净利润为5.97亿元,较去年同期增长90.56%。神州数码这边,其归属于上市公司股东的净利润为5.1亿元,同比增长17.5%,旗下神州鲲泰AI服务器实现收入5.6亿元,同比增长273.3%。

业绩超过50%以上的增长,是AI服务器大规模落地的结果。

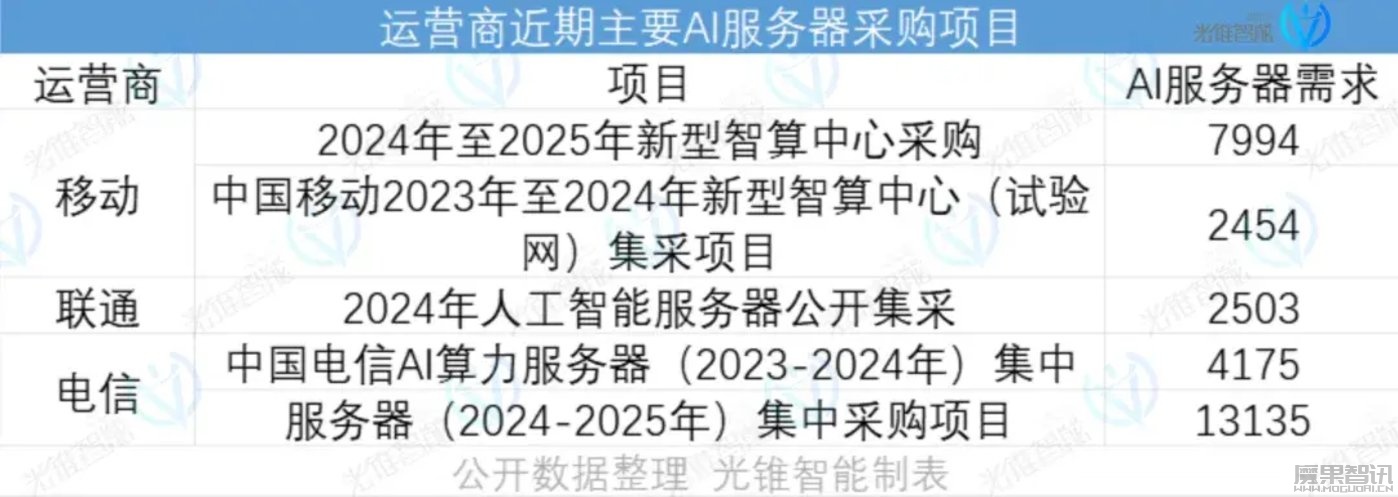

除了云厂商,运营商是AI服务器的主要需求方。自2023年开始,运营商们加大了对AI算力的布局。其中,电信和移动对AI服务器的需求增长了一倍以上。

同时,基于智算中心的需求也在快速推动AI服务器落地。根据Intel旗下AI芯片公司Habana中国区负责人于明扬在2024全球AI芯片峰会上的分享,近三年来大约有50多个政府主导的智算中心陆续建成,目前还有60多个智算中心项目正在规划和建设。

旺盛的AI服务器需求,改写了整个服务器行业的增长结构。

根据TrendForce集邦咨询近期发布的一份报告显示,在今年大型CSPs(云端服务供应商)对AI服务器的采购下,以产值估算,预计2024年AI服务器产值将达1870亿美元,成长率达69%。作为对比,一般服务器的预计年出货量增长仅为1.9%。

未来,随着CSP逐步完成智算中心的建设,AI服务器还将会随着更广泛的边缘计算需求,进一步加速增长。AI服务器的销售环节,也将随着CSP大批量集中采购切换至企业边缘计算的小批量购买。

换句话说,AI服务器厂商的议价权和盈利能力,将随着采购模式的变化进一步提升。

服务器厂商接下来还会靠AI赚的越来越多。如此趋势,跟AI服务器客户漫长的回本周期拉开了巨大差距。

以算力租赁的商业模式作为参考,行业内早就合计出了一笔账。算上智算中心配套的设备(存储、网络),在不考虑算力价格每年下降的前提下,采用英伟达H100作为算力卡的投资回报周期长达5年,采用性价比最高的英伟达4090显卡,回报周期也在两年以上。

如此一来,如何帮客户用好AI服务器,成了整个服务器行业最核心的竞争方向。

加速、稳定,AI服务器厂商各显神通

“大模型落地过程复杂,涉及分布式并行计算、算力调度、存储分配、大规模组网等多种先进技术和流程支持。”对于AI服务器落地应用中需要解决的问题,新华三集团智慧计算产品线高级产品经理冯良磊曾总结道。

上述难题,对应着AI服务器落地的两大类问题——算力优化和大规模使用。

一位销售人员对光锥智能也介绍到,“常见的客户需求,其一是硬件指标,第二是AI训练的支持能力,最后还有大规模集群的能力。”

其中,算力优化部分主要对应着AI服务器的异构计算问题。目前,行业提供的解决方案主要分为优化算力分配和异构芯片协作的两个大方向。

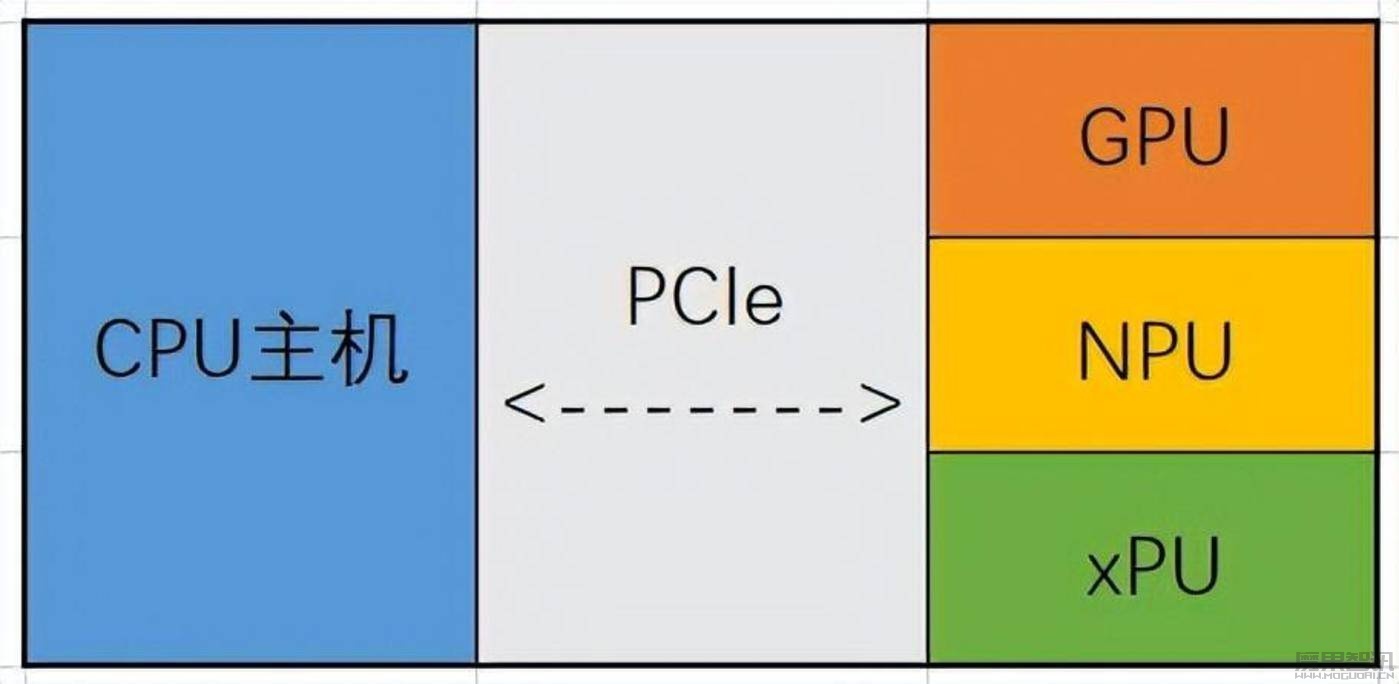

由于AI服务器的运作模式不再是CPU独立处理任务,而是CPU与算力硬件(GPU、NPU、TPU等)的协作。当前行业的主流解决模型,是用CPU把计算任务拆解到专用算力硬件。

这种算力分配模式,与英伟达CUDA的基本原理相同。CPU同时“带动”的算力硬件越多,整体算力就越大。

异构计算算力分配原理

对应到服务器硬件层面的改变,是AI服务器成了可以堆叠算力硬件的“积木”。AI服务器的体积开始“加大加粗”,从通用服务器的1U(服务器高度基本单位)升级至目前常见的4U、7U。

针对算力进一步优化,不少服务器厂商提出了自己的方案。例如新华三的傲飞算力平台支持对算力和显存按1%和MB的细粒度切分,并按需调度。联想的万全异构智算平台则是以知识库的形式,自动识别AI场景、算法和算力集群。客户只需输入场景和数据,即可自动加载最优算法,并调度最佳集群配置。

在另一边的异构芯片协作上,主要解决的是不同算力硬件服务器之间的协同问题。

由于英伟达GPU长时间将处于供不应求的状态,不少智算中心会选择将搭载了英伟达、AMD、华为昇腾、Intel等厂商GPU混用,或多种GPU混训一个AI大模型。如此一来,整个AI训练环节就会出现通信效率、互联互通、协同调度等一系列问题。

AI服务器搭载不同厂商AI芯片占比 来源:TrendForce

“服务器集群训练AI的过程,可以简单理解成‘一轮一轮’的进行。一个任务先被拆解到所有算力硬件,结果汇总后再更新至下一轮计算。如果过程配合不好,比如有的GPU算的慢,或者通信不畅,相当于其他算力硬件要‘一起等’。轮数多了,整个AI训练时长就被极大拖延。”对于异构算力硬件协作解决的实际问题,一位技术人员对光锥智能举了一个形象的例子来解释。

目前,解决该问题的主流方案是利用云管系统(包括调度、PaaS和MaaS平台)对整个AI训练(和神经网络)进行精细拆分。

例如,新华三的方案是建设一套异构资源管理平台,通过开发统一的集合通信库实现对不同厂商GPU的纳管,从而屏蔽不同厂商之间的差异。百度百舸异构计算平台的多芯混合训练方案,是将各类芯片融合成一个大集群,再支持整个训练任务。

大同小异的解决方案,其目标正如无问芯穹联合创始人兼CEO夏立雪总结,“打开水龙头前,我们不需要知道水是从哪条河里来的。”

异构计算问题解决后,意味着智算集群可选择的硬件种类得以彻底解放。服务器、算力芯片、AI Infra等厂商之间的配合,也有了协同效应,共同维护着AI服务器组建大规模算力集群的稳定性。

参考Meta公司使用算力集群的经验,AI大模型训练并非“一帆风顺”。据统计,Meta 16K H100集群的同步训练中,曾在54天内出现了466次作业异常。如何让服务器集群在出现问题后快速回到运行状态,主流的解决方案是在训练过程中加一道“防火墙”。

例如,联想的解决方案是“用魔法打败魔法”。通过使用AI模型预测AI训练故障的方式,联想的解决方案能在断点前优化备份。超聚变和华为昇腾则采用了简单直接的对策。当检测到节点故障时,自动隔离故障节点后,从最近的Checkpoint点恢复训练。

整体来看,AI服务器厂商在了解AI,实现算力优化和稳定性升级的过程中,提升自己的附加值。

借助AI对行业的改造,AI服务器的玩家们正在以垂直一体化的姿态,让服务器这个经典ToB行业焕发出新的价值。

AI让服务器厂商更有价值?

复盘历史,服务器厂商们一直被“困在”微笑曲线的中间地带。

第三次工业革命之后,随着服务器市场空间越来越大,一批又一批的服务器厂商诞生。

在PC时代,Wintel联盟的X86架构,催生了戴尔和惠普两家国际服务器巨头。在云计算时代,大量的数字化需求催生了浪潮、工业富联等一系列OEM厂商。

然而,就在服务器厂商在每年几百、几千亿营收的华袍下,净利润率却常年为个位数。在浪潮开创的JDM(联合设计制造)模式下,极致的生产制造带来的是净利率仅为1-2个点。

“微笑曲线形成的原因,并不是因为制造环节本身的问题。是不能掌握产业链核心技术和专利,只能标准化生产,无法具备不可替代性的结果。”对于服务器厂商的困境,一位国泰君安电子分析师对光锥智能如此解释道。

在AI时代,服务器厂商的价值正在随着AI重新定义算力应用而改变。对AI的垂直整合能力,成了当下服务器厂商角逐的中心。

聚焦到硬件层面,不少服务器厂商已经深入到了智算中心的建设环节。

例如针对PUE(电源使用效率),新华三、浪潮、超聚变、联想等厂商纷纷推出了液冷整机柜的解决方案。其中,新华三除了推出了硅光交换机(CPO)来降低整个机房的能耗外,还对整个网络产品线都进行了AI优化。另一边,在突破英伟达算力芯片限制层面,神州数码、联想等厂商在积极推进国产算力芯片的落地,共同实现中国芯片产业弯道超车。

在软件层面,服务器厂商还在积极挖掘AI的生产力属性,让业务不局限于卖硬件。

最常见的,是服务器厂商推出的AI赋能平台。其中,神州数码在神州问学平台上就整合了模型算力管理、企业私域知识和AI应用工程模块。神州数码通过原生AI平台的方式,将Agent能力融入到服务器的使用环节,让用户的使用过程“越用越好用”。

神州数码副总裁李刚对此评价称,“我们需要有这样一个平台,用于内嵌企业被环境验证过的Agent知识框架,同时还可以不断地去积淀新的Agent框架,这个就是神州问学AI应用工程平台的价值所在。”

新华三则是充分结合网络产品已有的优势,利用AIGC实现了通信领域的异常检测、趋势预测、故障诊断和智能调优。除了运维环节,新华三还发布了百业灵犀AI大模型,试图用通用大模型“带动”行业大模型的方式,进入到不同行业客户的业务环节,进而扩张原本ToB硬件的业务范围。

“通过不断的科技创新和持续的产品打磨,寻求AI潮流中的新突破,释放AI基础设施的新动能。”

正如联想集团副总裁、中国基础设施业务群总经理陈振宽总结,服务器厂商正是在不断加深AI垂直一体化的进程中,收获了如今利润率大涨的成果。

跳出制造的服务器厂商们,正在迎来属于自己的AI大时代。