5月21日讯 谷歌 DeepMind 日前推出了一款名为“Frontier Safety Framework”的 AI 安全框架,主要用于检测 AI 模型的风险情况,号称能够主动识别“未来可能酿成重大风险的 AI 能力”,向研究人员指出相关模型“究竟在哪些层面可能会被黑客利用”。

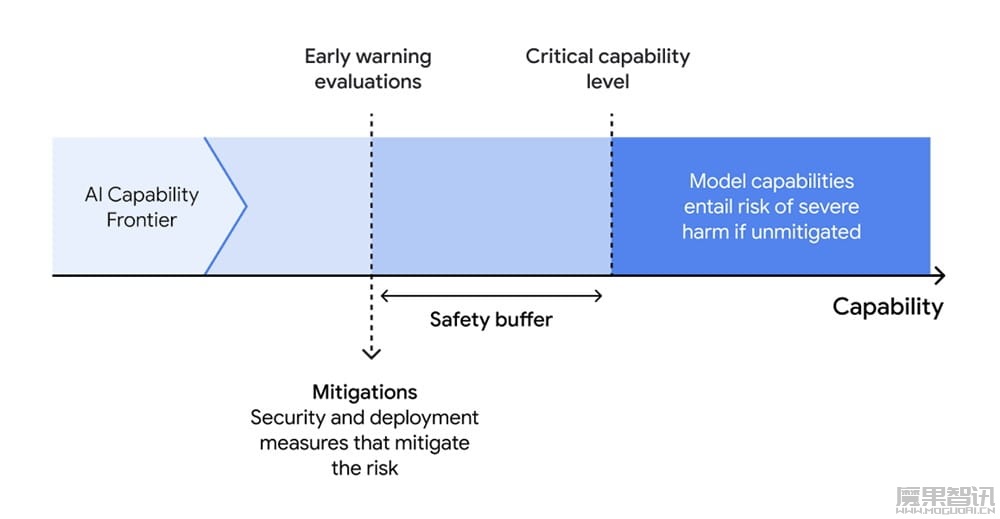

据介绍,DeepMind 目前公布的 Frontier Safety Framework 1.0 版本主要包含三个关键组件,即“识别模型是否具备酿成重大风险的能力”,“预估模型会在什么阶段具备安全隐患”、“智能优化模型防止其酿成风险”。

DeepMind 表示,该公司“一直在突破 AI 的边界”,所开发的模型已改变了他们对 AI 可能性的认知,虽然公司相信未来的 AI 技术将为社会带来宝贵的工具。但他们也意识到相关 AI 技术的风险性有可能对社会造成毁灭性的影响,因此他们正在逐步增强模型的安全性与可控性。

据悉,目前 DeepMind 仍在开发 Frontier Safety Framework,计划通过产业、学术及有关部门的合作来改善相关框架。