能源焦虑似乎是一个永恒的话题,从蒸汽机到内燃机,从煤炭到石油,世界的发展总是围绕着能源打转,到了AI时代,这一点也未曾改变。

OpenAI CEO Sam Altman在多个场合提到,未来的人工智能需要能源方面的突破,因为AI消耗的电力将远远超过人们的预期。马斯克也曾预言,未来两年内将由“缺硅”变为“缺电”。

数据显示,ChatGPT每天要响应大约2亿个请求,这个过程会消耗超过50万度电力。预计到2027年,整个人工智能行业每年将消耗85至134太瓦时(1太瓦时=10亿千瓦时)的电力,约等于北京市2023年全年的耗电总量(135.78太瓦时)。

巨大的能源消耗主要产生在两个方面,其一是驱动AI服务器计算、存储消耗的能源,其二则是为AI服务器降温消耗的能源,这里面前者占60%,后者占40%。

不过,虽然前者占比更高,但由于AI的发展对算力的需求越来越大,所以即便AI芯片的能效一直在提高,但还是无法改变整体功耗持续上涨的趋势。因此,如何降低服务器冷却时消耗的能源,就成为了降低AI运营成本、减少能源消耗的关键。

而为此,大到Google、微软这样的科技巨头,小到服务器研发供应商,尖端前沿如SpaceX也都在为此绞尽脑汁。

进阶的服务器从风冷到液冷

虽然大模型的风是从2023年才刮起来的,但服务器冷却并不是什么新课题。

1945年,世界上第一台通用计算机ENIAC诞生。为了解决ENIAC耗电量巨大且发热高的问题,当时的工程师就采用了风扇来为ENIAC降温,这差不多是最早的服务器制冷技术。

但风扇制冷的效果毕竟有限,而当时的计算机又都是大块头,且耗电量巨大。比如ENIAC重量大约在30吨左右,占地面积170平方米,功耗达到每小时150~174千瓦。

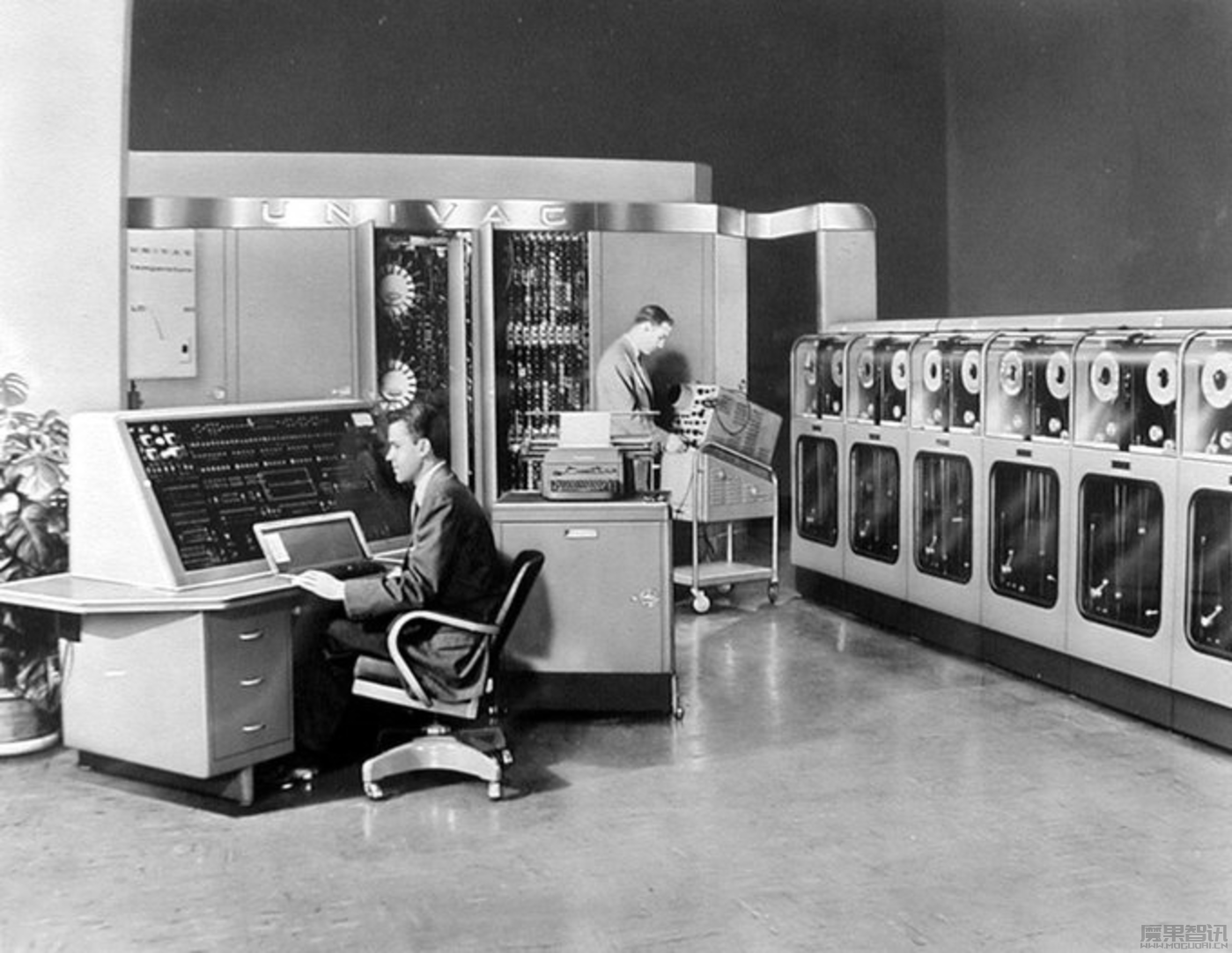

面对这样的庞然大物,仅靠风扇的制冷就有些力不从心了。所以到1951年,当美国雷明顿兰德公司推出第一款商用计算机UNIVAC I时,就已经用上了空调制冷。

空调最早发明在1902年,最初是为了给印刷厂保持恒温,后来陆续走入家庭,大约1920年的时候就已经在美国被广泛使用了。所以在1951年UNIVAC I面世时,空调系统已经异常成熟,当时雷明顿兰德公司就专门为UNIVAC I设计了一套中央空调制冷系统。

从此之后,空调制冷就逐渐成为大型计算机,以及后来的服务器机房最主要的制冷方式,并持续了将近一百年的时间,直到后来液冷技术登上舞台。

和空调制冷一样,液冷技术最早也不是应用在服务器场景的,而是应用在机械加工、电力变压器,或者航空航天等领域。其在服务器领域的应用,也不过是最近二十多年的事情。

这是因为全球互联网的浪潮一直到1994年前后才出现第一次爆发。从这之后,互联网公司为了提供高效的服务,大规模存储数据,才开始大规模建设和使用数据中心。

也因此,由于大量计算需求带来的芯片功耗提高,服务器密度增加等原因,传统的空调制冷设备就显得有些力有不逮,并开始限制芯片性能的提高。

苹果、惠普和戴尔供应商Liteon的副总裁Simon Ong表示:“我们发现采用风冷方式的芯片只能达到其性能的60%,并且会存在一定的过热问题,而液冷解决方案可以继续将计算性能提升至最优化。”

3月1日,在斯坦福大学举行的2024年SIEPR经济峰会上,黄仁勋表示,英伟达的下一代DGX AI服务器将采用液冷技术。

根据艾邦储能网统计,单个DGX H100系统消耗的功率大约为10kW,液冷可提高整体能效20-40%,1万个DGX系统能节省20-40兆瓦的功耗,按0.10美元/千瓦时计算,相当于每年节约2000-4000万美元能源成本。

液冷除了有更高的散热效率和更低的能耗水平,与风冷相比,它还能减少服务器的占地面积,即同样大小的机房,能够放下更多的服务器。种种优势让液冷技术逐步替代风冷,成为数据中心的主要冷却方式。

谷歌应该是全球范围内最早探索使用液冷技术的互联网科技企业之一。

2006年,谷歌前CEO埃里克·施密特在搜索引擎大会(SES San Jose 2006)上首次提出“云计算”(Cloud Computing)的概念,同时谷歌的数据中心也开始快速增长。

2009年,华尔街日报报道了谷歌开始探索液冷技术在数据中心的应用,以达到提高数据中心能源利用效率的目的。当时谷歌就表示液冷技术可以将数据中心的能耗降低40%。

也是这一年,惠普推出了一款名为ProLiant DL380 Gen8服务器,采用全新的液冷技术,可以将功耗降低40%。两年之后,IBM也推出了一款使用液冷技术的服务器,名为System x3550 M5,可以将功耗降低45%。

此后,微软、亚马逊、Facebook(现Meta)也开始纷纷跟进,并先后在2019年~2022年左右,将所有的数据中心的制冷方式都转换成液冷模式。

当然,液冷技术也分为很多类别,按照冷却液进入电子设备的方式不同,大致可分为芯片级液冷,浸没式液冷、喷淋式液冷、冷板式液冷等等。

比如芯片级液冷,就是将冷却液直接输送到芯片顶部,以吸收芯片产生的热量。这种形式降温彻底,但结构复杂、成本较高。浸没式液冷则是将整个电子设备浸泡在冷却液中,这种形式冷却均匀,但体积庞大,维护不便。

喷淋式液冷是将冷却液喷洒在电子设备上,虽然冷却效果差一些,但胜在结构简单,成本较低。冷板式液冷则是通过由铜管、铝板等高导热材料制成的冷板来降温,工作原理有些类似北方的暖气片,差别只是一个增温,一个降温。

目前,市面上使用最广泛的就是冷板式液冷。按照Gartner的数据,2023年全球数据中心液冷市场中,冷板式液冷技术的市场份额约为60%。

但最近两年,喷淋式液冷和浸没式液冷的市场份额也有所增加。Gartner的数据提到,2024年全球数据中心液冷市场中,喷淋式液冷技术和浸没式液冷技术的市场份额将分别达到约25%和约15%。

喷淋式液冷市场份额的增加,主要是因为它结构简单,也更易于安装和维护,是所有液冷技术中成本最低的一项。

联想在其2023年发布的《喷淋式液冷服务器白皮书》中提到,“喷淋式液冷技术具有良好的扩展性和灵活性,可以满足不同类型数据中心的需求。”这符合目前数字化转型过程中,越来越多企业建设私有云和自己的小数据中心的需求。

而与喷淋式液冷因为成本被选择不同,浸没式液冷市场份额增长的主要原因是效率。

因为随着人工智能,特别是大模型的发展,市场对数据中心的能源效率和服务器性能有了更高的要求,而最近两年,由于技术的成熟也导致沉浸式液冷的成本逐渐下降,进入更多企业可接受的范围。

整体上,液冷技术已经成为目前市场上最主要的服务器冷却方式。

上山下海的数据中心

虽然液冷技术对降低数据中心的能耗起到了巨大的作用,但对于高速增长的算力以及其带来的巨大能耗来说,仅靠传统的液冷方式还远远不够。

更何况液冷技术还存在一些问题,比如巨大的耗水量。

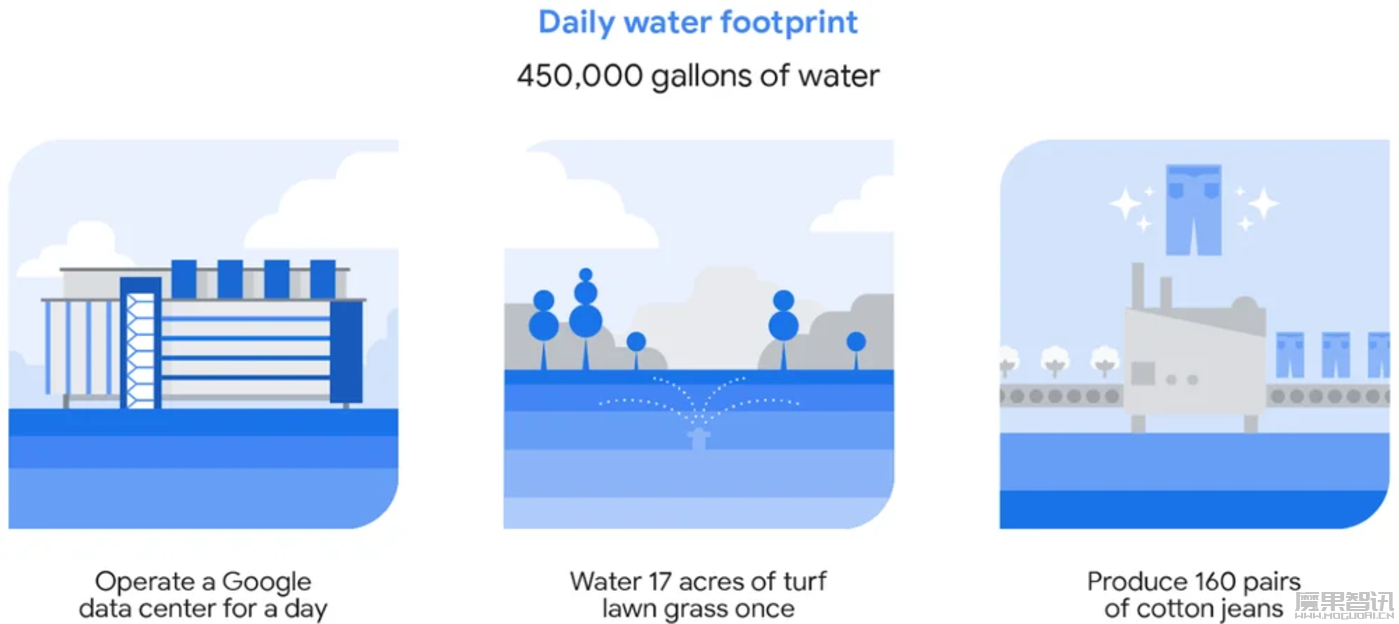

谷歌在其官网公布,2021年,谷歌数据中心平均每天消耗约45万加仑水。这大约相当于灌溉17英亩草坪一次的水量,或者种植用于生产160条牛仔裤的棉花的水量。

同年,谷歌全球数据中心机队消耗了约43亿加仑的水,相当于美国西南部每年灌溉和维护29个高尔夫球场所需的水量。

除此之外,随着全球ESG的理念越来越成为评判企业的重要标准,减碳甚至无碳成为了数据中心运行的重要标准。

为了解决这些问题,谷歌从很早就开始脑洞大开。2009年,谷歌在芬兰从一家造纸公司手里买下了一家造纸厂,开始着手将其改造成数据中心。

选择芬兰,一个原因是纬度高,自然环境温度低;另一个原因是这家造纸厂位于芬兰南部海岸,谷歌打算引导海水来为数据中心降温。

目前,这个项目的一期工程已经在2011年9月完工,谷歌初期投入了2亿欧元,但到目前为止,总投入已超过20亿欧元。谷歌的目标是在2030年以前让所有数据中心和园区全天候完全采用无碳能源来运营业务。

同样选择借助自然环境降温的还有Facebook,其2011年宣布在瑞典北部的一座名叫吕勒奥的城市建设数据中心。

选择这个地方的原因,其一是因为这是一座工业城市,电价便宜。其二则是因为这里纬度高。吕勒奥距离北极圈仅有110公里左右,每年十月份就开始飘雪,冬季平均气温大约在零下6°C至零下13.6°C,即使在夏天,平均温度也只有12°C – 20°C。

这个项目在2011年开始建设,巨大的风机将外部冷空气引入机房内,为成千上万台服务器物理降温。按照扎克伯格的说法,他们吕勒奥数据中心的工作效率比传统数据中心高10%,能耗却低40%。

与谷歌和Facebook在地面上想办法不同,艺高人胆大的微软则直接选择将数据中心扔进了海里。

微软认为,世界上一半以上的人口居住在距海岸约120英里的范围内。将数据中心放置在沿海城市附近的水域中,数据可以短距离传输到沿海社区。

2015年,微软一个名叫Natick的项目正式启动;2018年,该项目团队通过一个压力容器,将装有864台服务器的12个服务器机架沉入苏格兰海岸附近的海床。两年之后,他们将这个巨大圆柱体捞出,验证了项目的成功。

目前,这项技术在国内也同样得到了应用。

2022年12月,海南海底数据中心成功将装有近300台服务器的“海底数据舱”放入海底并开始向外输出数据,成为全球首个商业用的海底数据中心。

该项目总经理蒲定在接受环球时报的采访时提到,“以陆地1万个机柜为例,同等算力的海底数据中心,每年能节省用电总量1.75亿千瓦时、节省建设用地面积9.84万平方米、节省淡水15万吨。”

有企业将服务器放在海里,自然也有企业将服务器放在山里。

比如2017年,富士康的数据中心就落户在贵安新区的山洞里。设计人员将山底部的两头打通形成隧道,让空气对流,使山体内部温度低于外部的自然条件,成为机房服务器的天然 “空调房”。

贵州位于北纬26度左右,四季温度均衡,再加上天然的喀斯特地貌,让山体成为服务器的天然容器。

2021年,我国提出“东数西算”战略,贵州也因此成为我国西部最重要的数据中心之一。包括苹果、华为等众多头部企业都在贵州的大山里建立了自己的数据中心。

结语

如果说,谷歌、Meta等知名大公司之间的AI竞争,是人和人之间的技术竞赛,那么,AI对提升能源效率的迫切,本质上是对人与自然资源之间关系进行重新解构。

能量是守恒的,人类在获取一种更先进的生产力、试图无限扩大它的能力上限的同时,也必须去思考可能付出的代价是否超出了自己的极限,以寻找最优解来更科学地配置资源。

Open AI点燃了新一代AI争夺赛,将AI“吃电”量推向新的高峰,原先“看不见”的能源之战,也被摆在了明面。

虽然各家公司“上山下海”地寻求解决之道,但也可能面临一些争议和技术挑战,比如服务器放置在深海可能会影响海洋生态,而偏远地区的数据中心可能会涉及复杂的物流和维护问题。

这就像打开了“俄罗斯套娃”,每解决一个问题,会发现背后总是出现新的问题。

凡事皆有代价,当资源稀缺的时候,也是考验人类智慧的时候,或许,新的能源解决方案就在前方,只有人类开启“迫切”的阀门,才会更近距离地获取新的方案。