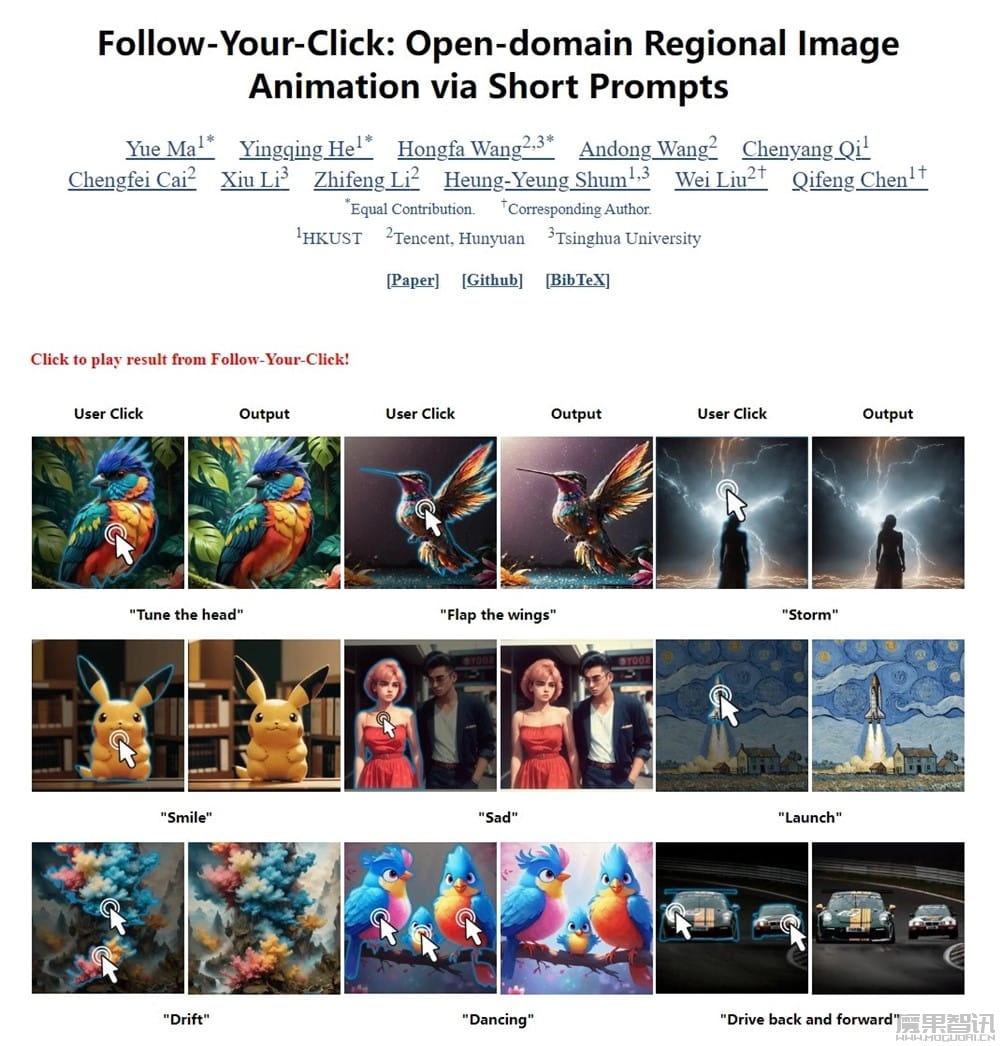

3月15日讯 腾讯和清华大学、香港科技大学联合推出全新图生视频模型 “Follow-Your-Click”,目前已经上架 GitHub(代码四月公开),同时还发表了一篇研究论文(DOI:2403.08268)。

这款图生视频模型主要功能包括局部动画生成和多对象动画,支持多种动作表达,如头部调整、翅膀拍动等。

据介绍, Follow-Your-Click 可以通过用户的点击和简短动作提示生成局部图像动画。用户只需点击对应区域,加上少量提示词,就可以让图片中原本静态的区域动起来,一键转换成视频,比如让物体微笑、跳舞或飘动。

除了能够控制单个对象的动画,这个框架还支持同时对多个对象进行动画处理,增加了动画的复杂性和丰富性。用户可以通过简单的点击和短语提示轻松地指定希望动画化的区域和动作类型,无需复杂的操作或详细描述。